Nexus, UCS e hipervisores

Recientemente nos hemos encontrado con problemas de instalación/configuración de virtualización en entornos HW innovadores para la creación de un mini centro de datos virtual.

La actividad se realizó en colaboración con el Consorcio Clara, con el que llevamos a cabo el diseño e implementación del rack/datacenter virtual en cuatro brazos. El equipo era UCS C200M1 con tarjetas CNA QLogic QLE8152 (FCoE 10GE) de doble puerto, un módulo Cisco Nexus 5010 FCoE + FC y un almacenamiento IBM FC de nivel de entrada

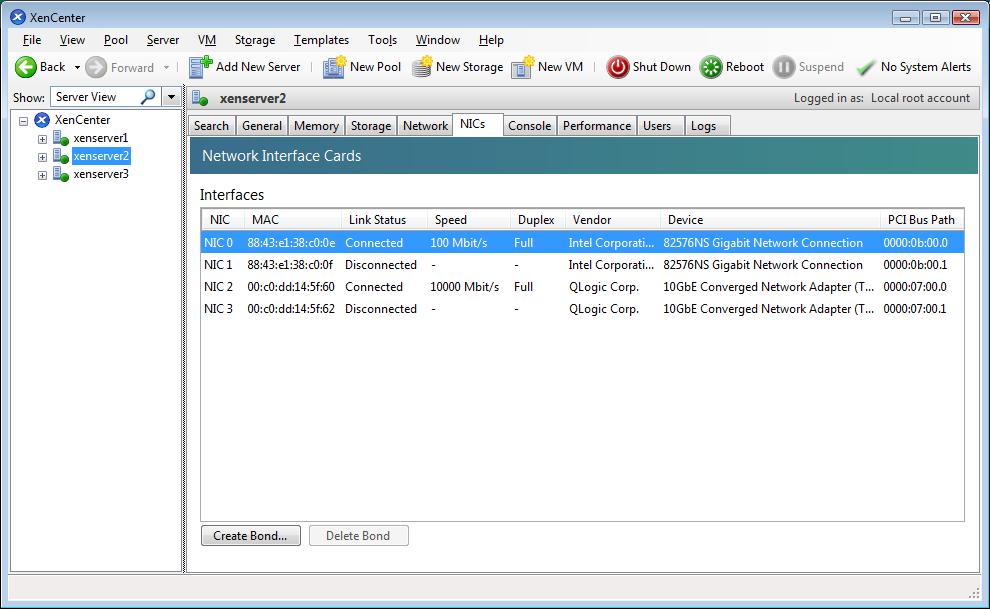

El uso de la configuración no estaba destinado a tener el valor de un sistema de producción, por lo que no estaba destinado a aplicaciones críticas para el negocio (no HA). Queremos publicar este caso, para exponer las metodologías de solución a emprender en caso de que los problemas debidos a hardware innovador y controladores demasiado recientes, bloqueen a otros profesionales. Hemos involucrado foros técnicos especializados y personal técnico especializado de varias partes del mundo. Inmediatamente nos movimos hacia la virtualización seleccionando uno de los dos hipervisores actualmente de excelencia en el mundo (ESXi4.0 y XenServer 5.6), en lugar de una solución de nube privada, porque habría requerido el sacrificio de uno de los servidores gemelos como administración. La solución que utiliza el hipervisor libre ESXi4.0 de Vmware habría requerido el uso del cliente VMware vSphere, pero sin un vCenter habría requerido varios accesos para cada servidor a administrar, mientras que el uso del hipervisor XenServer 5.6 gratuito de Citrix, permite administrar todas las máquinas a través de un único cliente gratuito de administración Citrix XenCenter. Los problemas han surgido, para ambos hipervisores, debido a las tarjetas CNA (Converged Network Adapter), ya que FCoE es una tecnología que se ha estado estableciendo desde hace poco tiempo, y además los servidores Cisco UCS también son demasiado recientes en el campo del hardware. En el caso de ESXi4.0 fue necesario instalar tres controladores para que todo funcionara correctamente, en el caso de XenServer 5.6 los drivers para los CNAs salieron mientras se probaban las instalaciones/configuraciones y a través de un canal abierto de feedback a los flamantes drivers el fantástico apoyo de los técnicos de Citrix nos proporcionó indicaciones para activar y configurar correctamente todo el potencial y funcionalidad del hardware.

Instalación con ESXi 4.0 :

Como puede ver en el siguiente hilo abierto en el foro de VMware , debe instalar:

- Proveedor CIM de canal de fibra y adaptador de red convergente QLogic – desde el sitio de Qlogic

- vmware-esx-drivers-net-qlge_400.1.0.0.39-1.0.4.00000.261179 – de VMware (componentes del controlador Ethernet para ESXi 4.0)

- vmware-esx-drivers-scsi-qla2xxx_400.831.k1.25vmw-1.0.4.00000.242037 – de VMware (componente de controlador de canal de fibra SCSI para ESX 4.0)

#Adapter Proveedor CIM

esxupdate –bundle offline-bundle.zip –nodeps –nosigcheck –maintenancemode update

FCoE FC-SCSI #driver

Actualización de ESXupdate –bundle=qlg.831.k1.25vmw-offline_bundle-242037.zip

#driver FCoE ETH

Actualización de ESXupdate –bundle=qlgc-qlge-100.21-offline_bundle-261179.zip

Luego probamos con la nueva versión ESXi 4.1, obteniendo resultados solo para la parte FC del CNA, mientras que para esta versión del hipervisor, actualmente no existen boletines para instalar los controladores capaces de desbloquear la parte ethernet (10GE) de las tarjetas CNA.

Instalación con XenServer 5.6 :

Para esta instalación seguimos las instrucciones de los controladores lanzados en el primer momento el 6 de julio de 2010

, actualizado posteriormente el 6 de agosto de 2010, tal vez precisamente por nuestros informes. A continuación, Citrix los complementó con un

nuevo artículo

donde también trae una actualización de firmware de las placas CNA.

De nuevo, hay diferentes procedimientos dependiendo de si los controladores se instalan después de XenServer o al mismo tiempo. en nuestro caso partieron de una instalación preexistente que hicimos antes del lanzamiento de los controladores, por lo que tuvimos que instalarlos en un XenServer en ejecución

mkdir -p /mnt/tmp

mount /dev/<path to cd-rom>/mnt/tmp

cd /mnt/tmp/

cd qlogic#qla2xxx

./install.sh

CD.. /qlogic#qlge/

./install.sh

CD/

umount /mnt/tmp# Creación manual de PIF para recoger por la API xen las «nuevas» interfaces de red – para cada puerto Eth

xe pif-introduce mac=<dirección-física> device=eth2 host-uuid=<UUID del host>

En este punto, el trabajo de configuración realizado previamente en el almacenamiento de IBM y el innovador dispositivo de red Nexus, dedicado a la tecnología FCoE, nos permitió completar el trabajo de manera brillante.

Para la configuración del Nexus nos echó mano el excelente vídeo de Jason Nash Varrow, que está relacionado con la configuración de un Nexus 5020 en un entorno ESX.

Los pasos que se tomaron para establecer el Nexo fueron:

- Activación de las funciones y licencias necesarias

- Activación del módulo FC

- Creación de una VLAN y una VSAN y asociación de las dos

- Creación de FCInterfaces virtuales (VFC) con asignación (Bind) a las respectivas interfaces físicas Ethernet 10G

- Asociar VFC y HR físicos con la VSAN creada

- Configuración del modo troncal en las respectivas interfaces Ethernet 10G

- Encendido de todas las interfaces afectadas

- Creación de alias para los WWN de los hosts que se van a vincular (los CNA) y asociación de los alias con la VSAN creada

- Asignación de alias a una zona

- Asignación de la zona creada a un conjunto de zonas

- Activación del conjunto de zonas

Todas las actividades se desarrollaron en un excelente ambiente de colaboración entre nosotros y el excelente y altamente capacitado personal del Consorcio Clara, de manera que se pudo agilizar enormemente la finalización de las obras.